I recenti trend in materia di tecnologia e innovazione spingono a riflettere su quale possa essere il potenziale impatto dell’intelligenza artificiale sul mercato dell’arte, vista la sua presenza ormai capillare nella vita quotidiana delle persone, con particolare riferimento ai più giovani.

Guardando ai possibili impatti positivi, si delinea l’opportunità che l’intelligenza artificiale contribuisca al processo di “democratizzazione” del mercato dell’arte e dei beni da collezione. L’analisi del linguaggio naturale potrebbe infatti supportare le attività di valutazione delle opere d’arte svolte da esperti (tra cui dealer, case d’asta e critici), potenziando accessibilità e trasparenza, nonostante il contributo “umano” rimanga centrale anche ai fini della corretta interpretazione dei risultati emergenti dall’utilizzo della nuova tecnologia, in particolare l’AI e l’AI Generativa. Quest’opportunità deriva dagli attuali sistemi di valutazione delle opere d’arte, che si basano infatti prevalentemente sul giudizio personale dei valutatori, tra cui critici, dealer o case d’asta, supportati dalle analisi dei dati storici di vendita per opere affini a quella in oggetto in termini di parametri tecnici, come dimensioni, materiali e tecniche utilizzate. I database utilizzati dai valutatori, considerano inoltre l’appartenenza a determinate correnti o “scuole”, insieme allo storico delle quotazioni, creando un sistema che, per quanto strutturato, presenta ancora margini di miglioramento, pur se, anche in questo caso, l’AI ha contribuito a migliorare le analisi storiche in quanto consente di analizzare i big data in modo completo e utilizzando tutto il patrimonio informativo che i dati storici rendono disponibili. Emerge, per esempio, la nuova possibilità di considerare maggiormente l’evoluzione del gusto del pubblico integrando le analisi quantitative sullo storico di mercato con gli input qualitativi derivanti da recensioni, opinioni del pubblico e articoli, che consentono di percepire in modo oggettivo i trend di gusto commentati dalla collettività. L’AI permette un monitoraggio costante e globale delle conversazioni sull’arte, analizzando in tempo reale le discussioni e opinioni in diverse lingue. Attraverso sofisticate analisi semantiche multilingue, questi sistemi possono identificare pattern emergenti nel sentiment globale nei confronti di un artista, di una corrente, anticipando tendenze e sviluppi del mercato. La capacità di prevedere trend valutativi basandosi su dati qualitativi può arricchire significativamente il processo di valutazione tradizionale. Il processo valutativo degli esperti può così essere integrato, includendo prospettive culturali diverse con una partecipazione veramente globale, più “democratica”, seppur mediata dall’Intelligenza Artificiale.

Le implicazioni etiche di questa trasformazione sono positive. La riduzione delle asimmetrie informative può portare maggiore equità e trasparenza nel mercato, aprendo la strada alla possibile creazione di un nuovo equilibrio tra expertise tradizionale e sentiment collettivo, a favore di un ecosistema più bilanciato e rappresentativo.

Esistono tuttavia rischi e possibili criticità da considerare. È infatti fondamentale preservare il ruolo dell’expertise dei critici, case d’asta e dealer, nonché minimizzare il rischio di una standardizzazione della produzione artistica, se orientata al profitto e basata sugli algoritmi di interpretazione del gusto artistico degli acquirenti.

Prendiamo il caso di Netflix, che ha rivoluzionato il mondo dell’intrattenimento usando algoritmi per analizzare i gusti del pubblico e creare contenuti di sicuro successo. Analogamente, la Generative AI oggi permette di creare opere d’arte attraverso algoritmi sempre più sofisticati. Questi sistemi, combinati con l’analisi del linguaggio naturale, potrebbero monitorare e interpretare le conversazioni globali sull’arte, comprendendo le preferenze del pubblico e le valutazioni dei critici in tempo reale. La capacità di analizzare discussioni in diverse lingue potrebbe consentire di identificare pattern globali nel gusto artistico e nelle tendenze di mercato, orientando le produzioni artistiche create da Generative AI ovvero dagli artisti in funzione delle informazioni rese disponibili dall’AI, verso ciò che più risulta attrattivo, e quindi vendibile, dalle analisi semantiche. Di fatto, come sosteneva Walter Benjamin già nel 1936 “l’avvento della riproducibilità tecnica trasforma radicalmente l’opera d’arte, spogliandola della sua unicità e autenticità tradizionale (la “perdita dell’aura”), ma aprendo anche nuove possibilità di fruizione e partecipazione sociale”.

Si profila uno scenario simile a quello già osservato nell’industria dell’intrattenimento, dove piattaforme come Netflix utilizzano l’analisi dei dati per generare contenuti ottimizzati per il massimo gradimento del pubblico. Nel contesto artistico, questo approccio potrebbe portare alla creazione di opere “su misura”, progettate algoritmicamente per massimizzare il successo commerciale. Il primo rischio etico è relativo alla potenziale standardizzazione della creatività. L’utilizzo di algoritmi predittivi per la creazione artistica potrebbe generare il rischio di orientare la creazione d’arte e portare sul mercato opere sempre più simili tra loro, progettate per soddisfare gusti medi e tendenze dominanti. Questa standardizzazione mina l’essenza stessa dell’arte come espressione di unicità e originalità, portando in evidenza il secondo rischio, relativo all’impoverimento culturale. La produzione di opere “facili” e immediatamente appetibili può portare a un progressivo impoverimento del panorama artistico, riducendo la diversità espressiva e la sperimentazione creativa. Terzo, ma non meno importante, è il rischio di manipolazione del mercato: l’utilizzo di AI per prevedere e influenzare i gusti del pubblico solleva questioni etiche sulla manipolazione del mercato dell’arte e sulla genuinità delle preferenze artistiche, nonché delle quotazioni di opere e artisti. La AI potrebbe portare, nello scenario peggiore, a “premiare” con quotazioni più alte le opere che seguano i pattern identificati dagli algoritmi, riducendo la competitività del mercato degli artisti che seguono invece la propria indole creativa.

La standardizzazione algoritmica rischia quindi, soprattutto per nuovi potenziali acquirenti d’arte e collezionisti non già “orientati” da un proprio gusto e da una propria sensibilità critica, o per nuovi artisti magari spinti da obiettivi di mercato dalle gallerie, di scoraggiare la sperimentazione artistica, penalizzando opere innovative ma di difficile comprensione immediata. Questo porterebbe ad una riduzione della diversità culturale nell’espressione artistica, limitando l’evoluzione naturale dei linguaggi artistici.

Ultimo elemento da considerare, nella relazione tra arte e AI, è il potenziale impatto sul ruolo dell’artista. La crescente automazione della creazione artistica solleva interrogativi sul ruolo umano dell’artista nel processo creativo, l’autenticità dell’espressione artistica, il valore dell’originalità nell’era della riproduzione algoritmica e infine la relazione tra creatività umana e artificiale.

In conclusione, è importante studiare e monitorare questo fenomeno, per garantire il mantenimento di un equilibrio tra innovazione tecnologica, preservazione dell’autenticità artistica e del ruolo della critica e delle metodologie di valutazione tradizionali. Anche nell’arte la AI dovrebbe essere utilizzata come strumento di supporto alla creatività umana, non come sostituto della stessa.

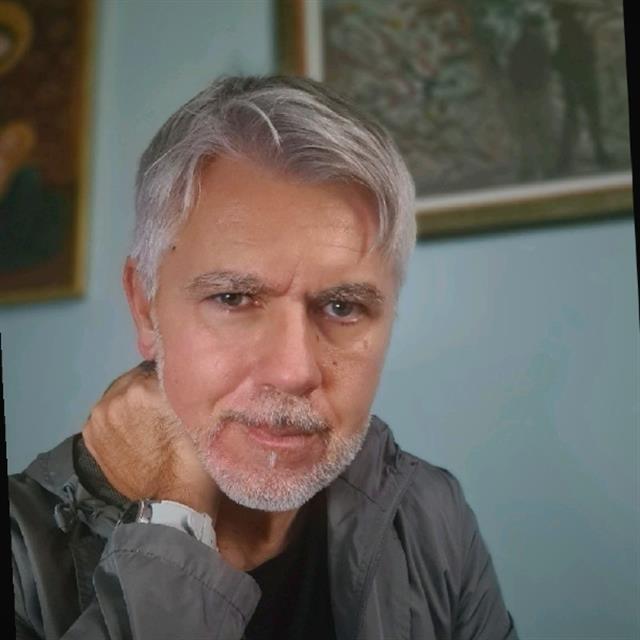

Cognitive Leader, è partner in AI & Data presso Deloitte Consulting e membro del Deloitte AI Institute, un think tank che riunisce esperti di settore, ricercatori e leader aziendali per esplorare il futuro dell’AI e il suo impatto trasformativo sul business e sulla società. Con 30 anni di comprovata esperienza sul campo è riconosciuto come opinion leader nel settore dell’AI e della Generative AI. Nel corso della sua carriera, ha ricoperto ruoli di prestigio come AI Tech Lead presso Harman e Team Lead AI di Samsung, dove ha guidato i team di ASR, open Q&A e TTS responsabili dello sviluppo di Samsung Bixby. La sua esperienza multiforme include anche posizioni come Head of Text Analytics presso Integris e AI Manager presso Synthema, dove ha collaborato con IBM su temi di innovazione fin dai primi anni 90. Negli anni ha saputo bilanciare l’attività manageriale con quella di ricerca, pubblicando oltre 25 articoli scientifici su AI e Text Mining. Il suo contributo si estende alla partecipazione in comitati scientifici per congressi internazionali (ASONAM, F-OSINT, EISIC e altri 13 congressi, per un totale di 32 edizioni, con CARMA 2024 come il più recente) e come revisore per “Annals of Information Systems” e “Data Mining for Social Network Data” di Springer”.